فرهنگ الگوریتمی علیه فرهنگ انسانی

1 دقیقه خوانده شده

به گزارش پایگاه خبری تحلیلی خبرنگاران و رسانه و به نقل از ایرنا؛ دروازهبانی اخبار فرایندی است که در آن اطلاعات به گونهای عامدانه فیلتر میشوند. سانسور اطلاعات در زمانهای گوناگون به شکلهای مختلفی صورت گرفته است. در رسانههای جمعی مانند تلویزیون و روزنامهها به گونهای دروازهبانی اخبار انجام میشود. اما با گسترش رسانههای دیجیتال و اینترنت این مسأله پایان نیافته است. حتماً شنیدهاید که امروزه، الگوریتم جستجوگر گوگل، نوع دسترسی ما به اطلاعات را تعیین میکند. یک الگوریتم مجموعهای از دستورالعملها است که برای انجام کار و رسیدن به اهدافی تنظیم میشود. شاید به نوع عملکرد الگوریتم اینستاگرام دقت کردهاید؛ اینکه چگونه پستهای مورد علاقه شما به نمایش گذاشته میشود. این نوع الگوریتمها به گونهای از هوش مصنوعی AI و یادگیری ماشینی ML استفاده میکنند که میتوانند علایق شما را تشخیص دهند. شما با دیدن پستهای مورد علاقه خود، زمان بیشتری را در پلتفرمهای شبکه اجتماعی سپری میکنید. البته باید گفت که این یک روایت خوشبینانه از الگوریتمها بود. الگوریتمها همیشه مطالب را در معرض دید شما قرار نمیدهند، گاهی آنها اطلاعاتی را از جلوی چشم شما دور میکنند.

فرهنگ الگوریتمی

همیشه اینگونه نیست که مردم حضور و سیطره الگوریتمها را احساس کنند. گاهی افراد جامعه، الگوریتم را به مثابه طبیعت و امر عادی تلقی میکنند. شاید انسانها به توصیههای یک الگوریتم بیشتر از نسخه یک پزشک اعتماد کنند. تا جایی که برخی ممکن است الگوریتم را همچون وحی درنظر بگیرند. این امر باعث گره خوردن هرچه بیشتر تفکر و رفتار ما به منطق الگوریتم شده است. تد استریفاس، استاد ارتباطات در آمریکا، از این شرایط به عنوان «فرهنگ الگوریتمی» یاد میکند. او کتابی که با همین عنوان دارد که مفصل به این موضوع پرداخته است. استریفاس معتقد است امروزه فرهنگ انسانی، به فرایند الگوریتمی پیوند خورده. در واقع فرهنگ الگوریتمی، فرهنگ انسانی را تحت تأثیر قرار داده است. استریفاس، فرهنگ الگوریتمی را استفاده از فرایندهای محاسباتی برای مرتبسازی، طبقهبندی و اولویتبندی افراد، مکانها و اطلاعات تعریف میکند که رفتار، تفکر و احساسات انسانها را تحت تأثیر قرار میدهد. اما آنقدر وجود الگوریتمها زیاد شده است که شاید متوجه حضور آنان نشویم؛ درست مانند یک ماهی که متوجه آب نمیشود.

حباب اطلاعاتی

پذیرش بیچون و چرای الگوریتمها مشکلات متعددی به وجود میآورد. الگوریتمها محصول برنامهنویسی و کدگذاریهای انسانی هستند، از همین جهت سوگیری و تعصبات انسانها بر روی ایجاد یک الگوریتم تأثیر میگذارد. الگوریتم میتواند تبعیض و نابرابریها را تقویت کند. یک الگوریتم توانایی این را دارد که اخباری را سانسور، و اتفاقات غیر مهم را پررنگ کند. هرگز نباید الگوریتم را یک سیستم خودکار و خنثی تلقی کنیم. برای تحلیل بهتر یک الگوریتم میتوانم اقتصاد سیاسی پشت آن را در نظر بگیریم. چراکه این مسأله بر روی نتایجی که یک الگوریتم منتشر میکند تأثیر میگذارد.

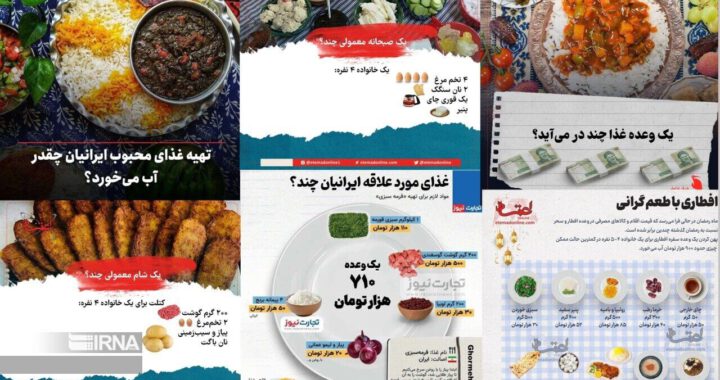

یک الگوریتم همچنین میتواند برای مدیریت رفتار انسانی استفاده شود. استراتژی شخصی سازی، به شرکتها کمک میکند تا سلایق شما را بشناسند و با توجه به علایق شما، سیاستگذاری کنند. پلتفرمها از این طریق میتوانند شما را به خود معتاد کنند. شخصی سازی توسط الگوریتمها منجر به قرارگرفتن مخاطب در یک حباب اطلاعاتی میشود. از بزرگترین مضرات حباب اطلاعاتی، فاصله گرفتن افراد جامعه از یکدیگر است. آنان به دلیل اینکه با نظرات مخالف خود روبرو نشدهاند، تصور میکنند که جامعه، فقط یک قشر دارد و از درک تکثر و سلایق مختلف در جامعه محروم میشوند. مستند معضل اجتماعی، فاصله گرفتن دموکراتها و جمهوری خواهان آمریکا از یکدیگر را به خوبی روایت کرده است. در واقع حباب اطلاعاتی از مهمترین عوامل دو قطبی شدن بین این دو گروه در آمریکا است.

البته باید گفت که الگوریتمها همیشه بر اساس سلایق ما عمل نمیکنند. گاهی ممکن است به صورت مغرضانه ما را از دیدن حقایق محروم کنند. مثلاً یک الگوریتم این توانایی را دارد تا اخبار مربوط به فلسطین دیده نشود و برعکس مطالب ناظر به همجنسبازان را بهگونهای بازتاب دهد که جامعه تصور کند اکثر افراد جامعه همجنسباز هستند.

جامعهشناسی توییتری

ظهور الگوریتمها قطعا کار جامعهشناسان و اصحاب رسانه را آسانتر نکرده است. جامعهشناسان و روزنامهنگاران که تعامل زیادی با مسائل اجتماعی دارند باید مراقب تأثیر الگوریتمها بر خودشان و جامعه باشند. سانسور وقایع مهم توسط الگوریتمها نباید جامعهشناسان و ژورنالیستها را از آن واقعه غافل کند. در واقع آنان نباید در دام الگوریتم دچار شوند. از طرفی متفکرین نباید در تحلیل جامعه مغلوب سوگیریهای الگوریتم شوند. الگوریتم شاید بخواهد قشری خاص را پرنگ کند و تصاویر و مطالب آنان را بازتاب دهد. این مسأله نباید باعث شود جامعهشناسان آن قشر خاص را به کل جامعه تعمیم دهند. یک روزنامهنگار فرهنگی را متصور شوید که توسط الگوریتمها تهدید میشود. او میخواهد درباره علاقه جوانان به یک موسیقی خاص گزارش تهیه کند. اما برای جمعآوری داده، به سایتها و شبکههای اجتماعی رجوع میکند. او غافل از اینکه سایت Spotify در پیشنهاد و بازتاب موسیقی جهت دار عمل میکند و یا اینکه شبکههای اجتماعی مطالب را طبقهبندی میکنند به این نتیجه میرسد که جوانان به یک موسیقی خاص علاقه زیادی دارند. اما او مغلوب الگوریتم شده است؛ چراکه نمیداند الگوریتم لزوماً بازتاب جامعه نسیت، بلکه میتواند ابزاری برای جهت دهی به جامعه باشد.

الگوریتم بازتاب انسان

سوگیری انسانی در ایجاد الگوریتمها تأثیر بسزایی دارد. این سوگیری میتواند ناشی از عقاید دینی، گرایشهای سیاسی و یا منافع اقتصادی باشد. از همین جهت لازم است قبل از مواجهه با الگوریتم، انسانی که در پشت آن وجود دارد را بشناسیم. امروزه برخی در برابر الگوریتم دچار ازخودبیگانگی شدهاند. آنها الگوریتم را مانند طبیعت یا امر بدیهی تصور میکنند. اما باید دانست که الگوریتم محصول دست خود ما انسانها است. هرچقدر که ما انسانها دچار تعصب، سوگیری و دشمنی باشیم، به همان اندازه الگوریتم هم همانگونه عمل میکند. چراکه الگوریتم بازتاب انسان است.

لینک کوتاه: http://khabarnegaranvaresane.ir/?p=16016